Улучшаем ранжирование сайта, не изменяя его контент

Что можно сделать с сайтом, не трогая контент (допустим, в случае, когда нет доступа к администраторской части), чтобы поисковые системы уделяли ему больше внимания и благодарили хорошими позициями в серпе и, соответственно, давали больше траффика? Ниже я привел несколько простых советов, как быстро улучшить позиции своего сайта.

1. Создайте и настройте файл robots.txt

Файл robots.txt, который должен находится в главной папке, может содержать в себе ряд полезных правил:

– Закрытие ненужных страниц (разделов) от индексации роботом.

Все разделы, которые не должны попасть в индекс, например, в случае дублирования контента или разделов, в которые может попасть только авторизованный пользователь (приватный форум) или же админка, необходимо (очень желательно) закрыть в файле robots.txt. При этом, с одной стороны, вы уменьшаете нагрузку на сервер и, с другой стороны, поисковый робот берет только нужный контент.

Пример подобного файла можно посмотреть тут: http://www.yandex.ru/robots.txt.

– Указание пути к xml карте сайта.

Подробней о карте сайта написано в следующем пункте.

– Время задержки между запросами робота.

Яндекс и Bing поддерживают эту директиву – Crawl-delay, которая указывает в секундах задержку между двумя обращениями робота к серверу. Очень полезно, когда робот поисковой системы сильно нагружает сервер. Как эта директива влияет на позиции сайта? Лишь косвенно, влияя на скорость отдачи страниц сервером.

Более подробно о том, как использовать файл robots.txt читайте в разделе помощи яндекса, и также у google.

Вот пример файла robots.txt в одном из самых простых случаев:

# Zdravstvui, robot, dorogoi –

# Golova iz vaty.

# Vot opyat ty k nam prishol

# S vidom vorovatym…

#

# Indeksirui vse podrad

# Pravdy ne skryvaya –

# Chtoby pishno rascvetal

# Saitik nash prekrasniy!

#

# Chtoby kazhdyi ohlamon

# S silnym zudom pyatok

# Mog vezde naiti legko

# Fotki, fil’mi, babok!User-agent: *

Disallow:

crawl-delay: 30Sitemap: http://myspace-webgraphics-software.net/sitemap.xml

2. Сделайте карту сайта (Sitemap)

Поисковые системы должны знать о том, по каким адресам находятся страницы вашего сайта, какой контент на них расположен и насколько он важен для посетителей. Если у вас простая навигация, когда любая страница доступна в 1-2 клика от главной, тогда sitemap может и не понадобится. В других случаях, когда структура сайта очень сложная и ресурс имеет множество разделов, желательно создать карту сайта в виде sitemap.xml или на крайний случай в виде sitemap.html.

Об использовании sitemap очень подробно описано в разделах помощи у яндекса или у google.

Вот пример карты сайта гугла: http://www.google.com/sitemap.html в HTML формате и в XML формате (грузится долго, наберитесь терпения).

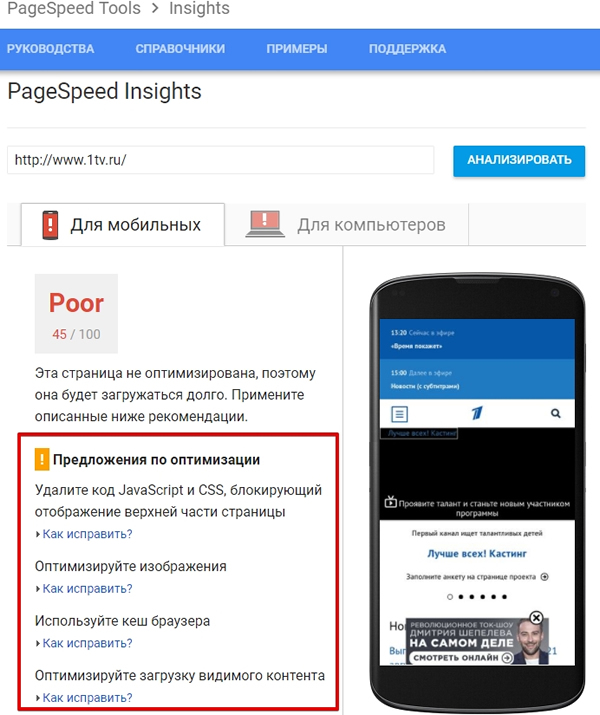

3. Увеличьте скорость отдачи страниц

Скорость, с которой отдаются страницы сайта сервером, уже является одним из факторов ранжирования в Google, а также косвенно влияет на другие факторы ранжирования во всех поисковых системах (например, среднее время нахождения пользователя на сайте, процент отказов и т.д.).

Как проверить скорость и при необходимости ускорить свой сервер?

Прежде всего, откройте главную страницу и попробуйте походить по ссылкам, используя навигацию. Устраивает ли вас скорость загрузки, как пользователя? Для точной проверки скорости в мозиле имеется множество плагинов (Tamper Data, Firebug и др.). Лучше всего использовать Firebug, в котором можно отследить количество загружаемых скриптов и их время загрузки, определяя, что больше всего тормозит на странице.

Ускорить сервер можно, переехав на хороший хостинг, добавив кеширование страниц, например, используя smarty в связке с apc (alternative php cache) и оптимизируя код страниц, убрав с них всё лишнее.

4. Склейте домены с www и без www

У многих сайтов в индексе страницы без www префикса дублируются аналогичными с www. Проверить это можно, используя специальные операторы поиска (url: в яндексе и site: в Google).

Когда-то вы ставили на свой сайт ссылки с www префиксом, сейчас без него, поэтому в ссылочном графе неразбериха и необходимо в нём навести порядок. Когда вы склеите оба сайта (варианта), прописав главный из них в файле robots.txt в директиве Host, то виц ресурса повысится, объединив виц каждого из них и, таким образом, вы можете ещё немного подняться в выдаче по своим запросам.

Для Google и других поисковых систем (кроме Яндекса) склейка происходит с помощью 301-го редиректа.

5. Склейте домен с более трастовым

Возможно, у вас имеются ряд зеркал и они не склеены между собой. Для повышения виц лучше будет, если вы их склеите по описанному выше методу. Также склейка домена с более трастовым доменом повысит авторитетность ресурса и поможет подняться ещё немного выше в серпе.

Дополнительно про траст можно почитать здесь.

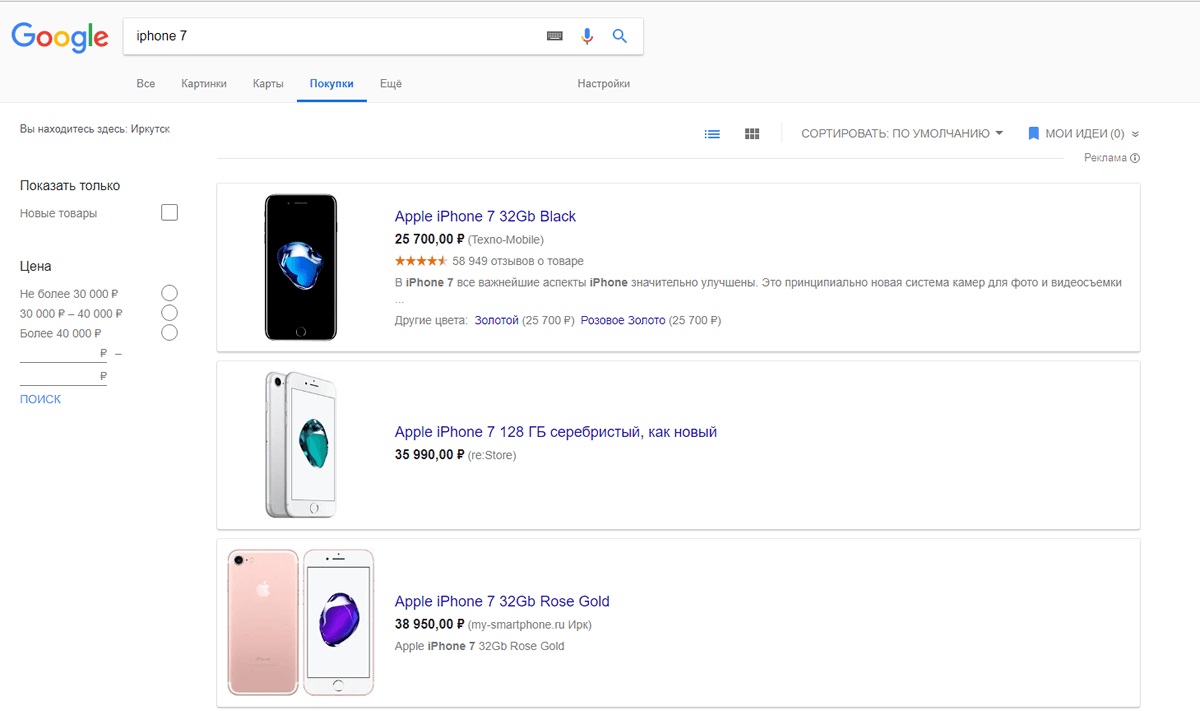

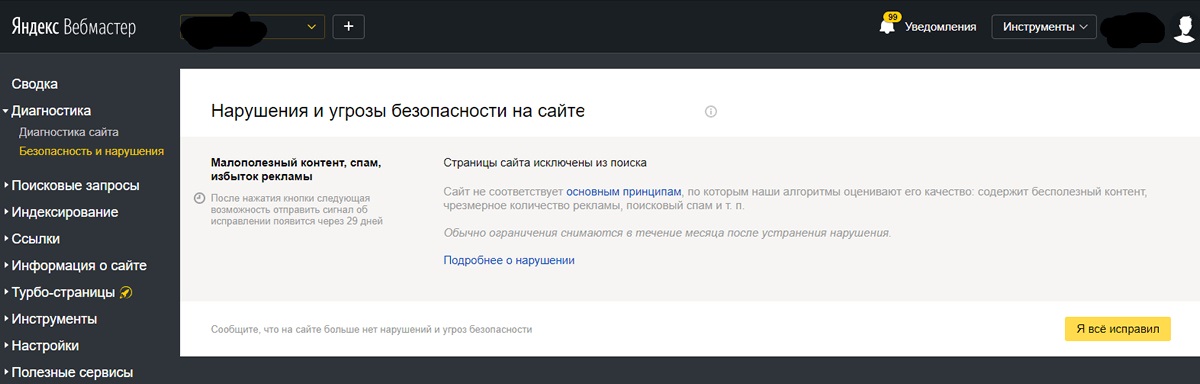

6. Присвойте сайту регион

В яндексе это делается в панели для вебмастеров, в Google тоже можно указать принадлежность домена, если он не имеет ярко выраженную гео-зону в названии. Если вы не присвоите домену регион, то Яндекс или другой поисковик сделает это за вас (по нескольким признакам), не всегда его выбор может совпадать с вашим желанием. Поэтому, если вы хотите, чтобы вас находили в нужном регионе, присвойте своему ресурсу тот, в котором вы продвигаете свой сайт. Если вы продвигаете товар или услугу по всем регионам (многим), то ищите другие выходы (например, сделайте под каждый регион свой раздел).

7. Вынесите скрипты и стили в отдельные файлы

Хорошей манерой является создание такого кода сайта, когда скрипты и стили вынесены в отдельные файлы. С одной стороны, они перестают засорять код, а с другой, уменьшают размер страницы, позволяя серверу быстрее отдавать её посетителям (и в том числе роботам поисковых систем). Уделяйте много внимания дизайну (внешнему виду) сайта, но также уделяйте достаточно внимания коду (внутреннему виду) сайта, он тоже влияет (пусть в некоторых случаях и косвенно) на ранжирование и позицию ресурса в серпе.

8. Замените 404-ые ошибки на 301-ые

С одной стороны, когда посетитель ввел несуществующий адрес вашего сайта, необходимо выдать ему соответствующее сообщение, это будет корректно по отношению к посетителю, но с другой стороны, можно не спрашивая, направить его на нужную страницу или, если нету таковой, на главную страницу сайта. То есть, избавившись от 404-ых ошибок, заменив их 301-ыми редиректами на существующие, мы повысим вес последних страниц (склеив несуществующие с существующими), а это поможет нам еще чуть-чуть в общей задаче – повысить траффик с поисковых систем.

9. Используйте кросспостинг

Самый простой пример кросспостинга – настроить FeedBurner и дублировать анонсы в сервис микроблогов Твиттер. Также вы можете кросспостить материалы сайта (статьи, новости и обсуждения) на другие блог-платформы. Это, безусловно, улучшит видимость вашего сайта в сети и увеличит количество обратных ссылок, что повлечет за собой очередное повышение рейтинга в серпе.

Если у вас имеются дополнительные методы улучшения ранжирования без изменения контента сайта – поделитесь ими с нами в комментариях.

|

Что можно сделать с сайтом, не трогая контент (допустим, в случае, когда нет доступа к администраторской части), чтобы поисковые системы уделяли ему больше внимания и благодарили хорошими позициями в |

РэдЛайн, создание сайта, заказать сайт, разработка сайтов, реклама в Интернете, продвижение, маркетинговые исследования, дизайн студия, веб дизайн, раскрутка сайта, создать сайт компании, сделать сайт, создание сайтов, изготовление сайта, обслуживание сайтов, изготовление сайтов, заказать интернет сайт, создать сайт, изготовить сайт, разработка сайта, web студия, создание веб сайта, поддержка сайта, сайт на заказ, сопровождение сайта, дизайн сайта, сайт под ключ, заказ сайта, реклама сайта, хостинг, регистрация доменов, хабаровск, краснодар, москва, комсомольск |

|

Что можно сделать с сайтом, не трогая контент (допустим, в случае, когда нет доступа к администраторской части), чтобы поисковые системы уделяли ему больше внимания и благодарили хорошими позициями в |

РэдЛайн, создание сайта, заказать сайт, разработка сайтов, реклама в Интернете, продвижение, маркетинговые исследования, дизайн студия, веб дизайн, раскрутка сайта, создать сайт компании, сделать сайт, создание сайтов, изготовление сайта, обслуживание сайтов, изготовление сайтов, заказать интернет сайт, создать сайт, изготовить сайт, разработка сайта, web студия, создание веб сайта, поддержка сайта, сайт на заказ, сопровождение сайта, дизайн сайта, сайт под ключ, заказ сайта, реклама сайта, хостинг, регистрация доменов, хабаровск, краснодар, москва, комсомольск |

Дайджест новых статей по интернет-маркетингу на ваш email

Новые статьи и публикации

- 2024-04-22 » Комментирование кода и генерация документации в PHP

- 2024-04-22 » SEO в России и на Западе: в чем основные отличия

- 2024-04-22 » SEO для международного масштабирования

- 2024-04-22 » Как использовать XML-карты для продвижения сайта

- 2024-04-22 » Цифровой маркетинг: инструменты для продвижения и рекламы в 2024 году

- 2024-04-22 » Что такое CSS-модули и зачем они нам?

- 2024-04-17 » 23 сервиса для эффективного экспресс-аудита любого сайта

- 2024-04-08 » Яндекс переходит на новую версию Wordstat

- 2024-04-08 » Яндекс интегрировал в свой облачный сервис эмпатичную нейросеть

- 2024-04-08 » Новая версия нейросети Claude превзошла по мощности аналоги Google и OpenAI

- 2024-04-08 » Как пользоваться GPT 4 и Claude бесплатно и без VPN

- 2024-03-13 » Стратегии SEO на 2024 год

- 2024-03-13 » Как использовать анимацию с помощью JavaScript-библиотеки GSAP

- 2024-03-13 » Использование GSAP 3 для веб-анимации

- 2024-03-13 » Cогласование топографической съёмки с эксплуатирующими организациями

- 2024-02-19 » Теряются лиды? Как настроить сквозную аналитику

- 2024-02-17 » Мерч и IT: на что обратить внимание в 2024 году

- 2024-02-16 » Копируем с RSync: основные примеры синхронизации файлов

- 2024-02-15 » Лучшие noCode AI платформы для создания диалоговых ботов

- 2024-02-14 » Факторы ранжирования Google 2024 — исследование Semrush

- 2024-02-12 » Перенос сайта на другой хостинг

- 2024-02-05 » В России сформирован реестр хостинг-провайдеров

- 2024-02-04 » Использование SSH для подключения к удаленному серверу Ubuntu

- 2024-02-03 » Подключаемся к серверу за NAT при помощи туннеля SSH. Простая и понятная инструкция

- 2024-02-02 » Настройка CI/CD для Gitlab-репозитория: схемы и гайд по шагам

- 2024-02-01 » GitLab CI Pipeline. Запуск сценария через SSH на удаленном сервере

- 2024-01-29 » Introduction to GitLab’s CI/CD for Continuous Deployments

- 2024-01-26 » Настройка GitLab CI/CD

- 2024-01-25 » Установка shell gitlab runner

- 2024-01-25 » Установка и регистрация gitlab-runner в docker контейнере

"Тот, кто в совершенстве овладеет электронной почтой, будет миллионером в двадцать первом веке." |

Мы создаем сайты, которые работают! Профессионально обслуживаем и продвигаем их !

Как мы работаем

Заявка

Позвоните или оставьте заявку на сайте.

Консультация

Обсуждаем что именно Вам нужно и помогаем определить как это лучше сделать!

Договор

Заключаем договор на оказание услуг, в котором прописаны условия и обязанности обеих сторон.

Выполнение работ

Непосредственно оказание требующихся услуг и работ по вашему заданию.

Поддержка

Сдача выполненых работ, последующие корректировки и поддержка при необходимости.

Мы создаем практически любые сайты от продающих страниц до сложных, высоконагруженных и нестандартных веб приложений! Наши сайты это надежные маркетинговые инструменты для успеха Вашего бизнеса и увеличения вашей прибыли! Мы делаем красивые и максимально эффектные сайты по доступным ценам уже много лет!

Мы создаем практически любые сайты от продающих страниц до сложных, высоконагруженных и нестандартных веб приложений! Наши сайты это надежные маркетинговые инструменты для успеха Вашего бизнеса и увеличения вашей прибыли! Мы делаем красивые и максимально эффектные сайты по доступным ценам уже много лет! Комплексный подход это не просто продвижение сайта, это целый комплекс мероприятий, который определяется целями и задачами поставленными перед сайтом и организацией, которая за этим стоит. Время однобоких методов в продвижении сайтов уже прошло, конкуренция слишком высока, чтобы была возможность расслабиться и получать \ удерживать клиентов из Интернета, просто сделав сайт и не занимаясь им...

Комплексный подход это не просто продвижение сайта, это целый комплекс мероприятий, который определяется целями и задачами поставленными перед сайтом и организацией, которая за этим стоит. Время однобоких методов в продвижении сайтов уже прошло, конкуренция слишком высока, чтобы была возможность расслабиться и получать \ удерживать клиентов из Интернета, просто сделав сайт и не занимаясь им...

Мы оказываем полный комплекс услуг по сопровождению сайта: информационному и техническому обслуживанию и развитию Интернет сайтов.

Мы оказываем полный комплекс услуг по сопровождению сайта: информационному и техническому обслуживанию и развитию Интернет сайтов.

Контекстная реклама - это эффективный инструмент в интернет маркетинге, целью которого является увеличение продаж. Главный плюс контекстной рекламы заключается в том, что она работает избирательно.

Контекстная реклама - это эффективный инструмент в интернет маркетинге, целью которого является увеличение продаж. Главный плюс контекстной рекламы заключается в том, что она работает избирательно.